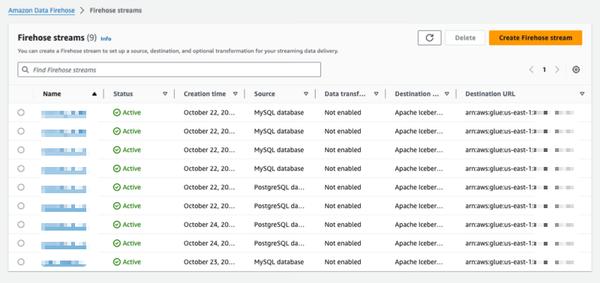

Amazon Data Firehose는 PostgreSQL, MySQL과 같은 데이터베이스의 변경 사항을 캡처하고 Amazon S3의 Apache Iceberg 테이블에 업데이트를 복제하는 새로운 기능을 프리뷰로 발표했습니다. 이 기능은 트랜잭션 성능에 영향을 주지 않고 데이터베이스 업데이트를 스트리밍하기 위한 간단한 엔드 투 엔드 솔루션을 제공합니다. 사용자는 몇 분 안에 Data Firehose 스트림을 설정하여 데이터베이스에서 변경 데이터 캡처(CDC) 업데이트를 제공할 수 있습니다. 이제 다양한 데이터베이스에서 Amazon S3의 Iceberg 테이블로 데이터를 쉽게 복제하고 최신 데이터를 사용하여 대규모 분석 및 머신 러닝(ML) 애플리케이션을 실행할 수 있습니다. AWS 기업 고객은 일반적으로 트랜잭션 애플리케이션에 수백 개의 데이터베이스를 사용합니다. 최신 데이터에 대해 대규모 분석 및 ML을 수행하려면 테이블에 레코드가 삽입, 수정 또는 삭제될 때와 같이 데이터베이스에서 변경된 사항을 캡처하고 Apache Iceberg와 같은 오픈 소스 테이블 형식으로 데이터 웨어하우스 또는 Amazon S3 데이터 레이크에 업데이트를 제공해야 합니다. 많은 고객이 데이터베이스에서 정기적으로 읽기 위해 추출, 변환 및 로드(ETL) 작업을 개발합니다. 그러나 ETL 리더는 데이터베이스 트랜잭션 성능에 영향을 미치고 배치 작업은 데이터를 분석에 사용할 수 있게 되기까지 몇 시간의 지연을 추가할 수 있습니다. 이를 완화하기 위해 고객은 데이터베이스에서 변경된 사항을 스트리밍하려고 하며, 이를 CDC 스트림이라고 합니다. 이 새로운 데이터 스트리밍 기능을 통해 Data Firehose는 데이터베이스에서 Amazon S3의 Apache Iceberg 테이블로 CDC 스트림을 가져오고 지속적으로 복제하는 기능을 추가합니다. 사용자는 소스와 대상을 지정하여 Data Firehose 스트림을 설정합니다. Data Firehose는 초기 데이터 스냅샷과 선택한 데이터베이스 테이블에 대한 모든 후속 변경 사항을 데이터 스트림으로 캡처하고 복제합니다. CDC 스트림을 가져오기 위해 Data Firehose는 데이터베이스 복제 로그를 사용하여 데이터베이스 트랜잭션 성능에 대한 영향을 줄입니다. 데이터베이스 업데이트의 양이 변동하는 경우 Data Firehose는 데이터를 자동으로 분할하고 전달될 때까지 레코드를 유지합니다. 사용자는 용량을 프로비저닝하거나 클러스터를 관리할 필요가 없습니다. Data Firehose는 초기 스트림 생성 중에 데이터베이스 테이블과 동일한 스키마를 사용하여 Apache Iceberg 테이블을 자동으로 생성하고 소스 스키마 변경 사항에 따라 대상 스키마를 자동으로 발전시킬 수도 있습니다. 완전히 관리형 서비스인 Data Firehose는 오픈 소스 구성 요소, 소프트웨어 업데이트 또는 운영 오버헤드의 필요성을 제거합니다.

Amazon Data Firehose를 사용하여 데이터베이스에서 Apache Iceberg 테이블로 변경 사항 복제(프리뷰)

AWS