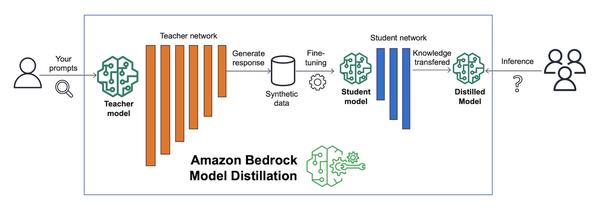

Amazon은 특정 사용 사례에 맞춰 Distilled 모델을 만드는 프로세스를 자동화하는 Amazon Bedrock Model Distillation의 프리뷰 버전을 발표했습니다. 이 기능은 교사 모델이라는 대규모 기반 모델(FM)에서 응답을 생성하고 생성된 응답으로 학생 모델이라는 더 작은 FM을 미세 조정합니다. 데이터 합성 기술을 사용하여 교사 모델의 응답을 개선합니다. 그런 다음 Amazon Bedrock은 최종 Distilled 모델을 추론을 위해 호스팅하여 사용 사례에 맞춰 교사 모델에 가까운 정확도로 더 빠르고 비용 효율적인 모델을 제공합니다. 이 새로운 기능에 정말 감명받았습니다. 생성 AI 모델을 사용하고 싶지만 지연 시간과 비용이 걱정되는 고객에게 매우 유용할 것이라고 생각합니다. 대규모 모델을 소규모 모델로 Distillation하면 고객은 정확도를 유지하면서 지연 시간과 비용을 줄일 수 있습니다. 이 기능은 생성 AI 분야의 판도를 바꿀 것이라고 생각합니다.

Amazon Bedrock Model Distillation으로 더 빠르고 비용 효율적이며 매우 정확한 모델 구축(프리뷰)

AWS