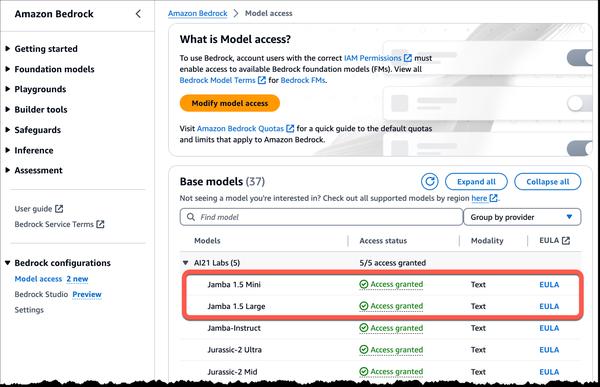

AWS와 AI21 Labs는 Amazon Bedrock에서 AI21 Labs의 강력한 새로운 대규모 언어 모델(LLM)인 Jamba 1.5 제품군을 사용할 수 있다고 발표했습니다. 이러한 모델은 광범위한 애플리케이션에서 속도, 효율성 및 성능을 제공하는 긴 컨텍스트 언어 기능에서 상당한 발전을 나타냅니다.

Jamba 1.5 모델은 트랜스포머 모델 아키텍처와 구조화된 상태 공간 모델(SSM) 기술을 결합한 고유한 하이브리드 아키텍처를 활용합니다. 이 혁신적인 접근 방식을 통해 Jamba 1.5 모델은 기존 트랜스포머 모델의 고성능 특성을 유지하면서 최대 256K 토큰의 긴 컨텍스트 창을 처리할 수 있습니다.

Jamba 1.5 모델의 주요 강점은 다음과 같습니다.

* 긴 컨텍스트 처리: 256K 토큰 컨텍스트 길이를 통해 Jamba 1.5 모델은 긴 문서 요약 및 분석, 에이전시 및 RAG 워크플로우와 같은 엔터프라이즈 애플리케이션의 품질을 향상시킬 수 있습니다.

* 다국어: 영어, 스페인어, 프랑스어, 포르투갈어, 이탈리아어, 네덜란드어, 독일어, 아랍어, 히브리어를 지원합니다.

* 개발자 친화적: 구조화된 JSON 출력, 함수 호출에 대한 기본 지원, 문서 객체를 다이제스트하는 기능.

* 속도 및 효율성: AI21은 Jamba 1.5 모델의 성능을 측정했으며, 이 모델이 비슷한 크기의 다른 모델보다 긴 컨텍스트에서 최대 2.5배 빠른 추론을 보여준다는 것을 공유했습니다.

Jamba 1.5 모델은 쌍으로 연결된 문서 분석, 규정 준수 분석, 긴 문서에 대한 질문 답변과 같은 사용 사례에 적합합니다. 여러 소스의 정보를 쉽게 비교하고, 구절이 특정 가이드라인을 충족하는지 확인하고, 매우 길거나 복잡한 문서를 처리할 수 있습니다.

AI21 Labs의 Jamba 1.5 모델 제품군은 현재 미국 동부(버지니아 북부) AWS 리전의 Amazon Bedrock에서 정식 출시되었습니다.

이러한 모델은 언어 처리 분야에서 중요한 진전을 나타낸다고 생각합니다. 긴 컨텍스트를 처리할 수 있으므로 개발자와 기업에게 광범위한 새로운 가능성이 열립니다. 이러한 모델을 사용하여 어떤 혁신적인 애플리케이션이 개발될지 기대됩니다.