Google Cloud에서 NVIDIA L4 GPU를 지원하는 Cloud Run 프리뷰 버전을 발표했습니다. 이는 Cloud Run 개발자에게 다음과 같은 여러 가지 새로운 사용 사례를 제공합니다.

* Google의 오픈소스 Gemma(2B/7B) 모델이나 Meta의 Llama 3(8B)와 같은 가벼운 오픈 모델을 사용하여 실시간 추론을 수행하고, 사용자 지정 챗봇을 구축하거나 즉석에서 문서 요약을 수행하는 동시에 급증하는 사용자 트래픽을 처리하도록 확장할 수 있습니다.

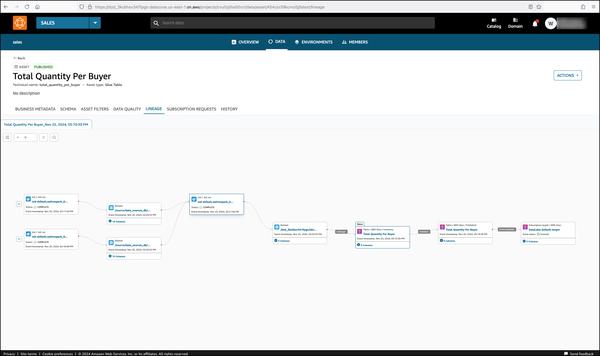

* 회사 브랜드에 맞게 조 tailored된 이미지 생성과 같이 맞춤형으로 미세 조정된 생성형 AI 모델을 제공하고, 아무도 사용하지 않을 때는 축소하여 비용을 최적화합니다.

* 온디맨드 이미지 인식, 동영상 트랜스코딩 및 스트리밍, 3D 렌더링과 같이 컴퓨팅 집약적인 Cloud Run 서비스의 속도를 높입니다.

완전 관리형 플랫폼인 Cloud Run을 사용하면 Google의 확장 가능한 인프라에서 코드를 직접 실행할 수 있으며, 컨테이너의 유연성과 서버리스의 단순성을 결합하여 생산성을 높일 수 있습니다. Cloud Run을 사용하면 프런트엔드 및 백엔드 서비스 실행, 일괄 작업 처리, 웹사이트 및 애플리케이션 배포, 대기열 처리 워크로드 처리를 기본 인프라를 관리할 필요 없이 수행할 수 있습니다.

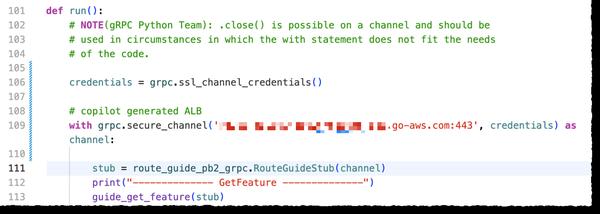

동시에 AI 추론을 수행하는 많은 워크로드, 특히 실시간 처리가 필요한 애플리케이션은 응답성이 뛰어난 사용자 환경을 제공하기 위해 GPU 가속이 필요합니다. NVIDIA GPU 지원을 통해 선택한 LLM을 사용하여 온디맨드로 온라인 AI 추론을 몇 초 만에 수행할 수 있습니다.

초기 고객들은 Cloud Run과 NVIDIA GPU의 조합에 큰 기대를 하고 있습니다.