Meta는 Amazon Bedrock에서 향상된 기능, 더 광범위한 적용성 및 멀티모달 이미지 지원을 갖춘 획기적인 언어 모델 제품군인 Llama 3.2 모델을 출시했습니다. 이번 출시는 대규모 언어 모델(LLM)의 큰 진전을 나타내며 다양한 사용 사례에서 향상된 기능과 더 광범위한 적용성을 제공합니다.

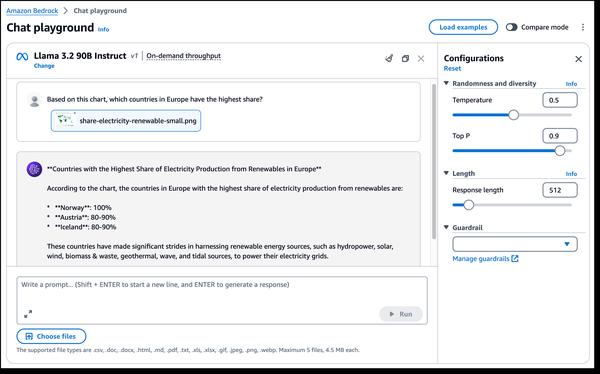

Llama 3.2의 가장 흥미로운 측면 중 하나는 멀티모달 비전 기능의 도입입니다. 새로운 90B 및 11B 모델은 이미지 이해 및 시각적 추론을 위해 설계되었으며 이미지 캡션, 이미지 텍스트 검색, 시각적 질문 답변과 같은 애플리케이션의 가능성을 열어줍니다. 이러한 기능은 다양한 분야에서 이미지와 상호 작용하고 이미지를 활용하는 방식에 혁명을 일으킬 가능성이 있습니다.

또한 Llama 3.2는 에지 장치에 적합한 경량 모델을 제공합니다. 1B 및 3B 모델은 대기 시간 단축 및 성능 향상을 통해 리소스 효율성을 높이도록 설계되었으며 기능이 제한된 장치의 애플리케이션에 이상적입니다. 이는 모바일 장치에서 보다 지능적인 AI 기반 쓰기 지원 및 고객 서비스 애플리케이션 개발로 이어질 수 있습니다.

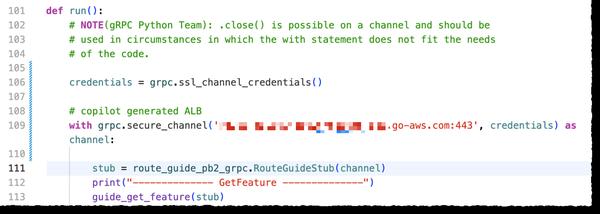

또한 Llama 3.2는 표준 도구 체인 구성 요소 및 에이전트 애플리케이션을 구축하기 위한 표준화된 인터페이스인 Llama Stack을 기반으로 구축되어 구축 및 배포가 그 어느 때보다 쉬워졌습니다. 이는 개발자에게 Llama 모델을 애플리케이션에 통합하는 표준화되고 효율적인 방법을 제공합니다.

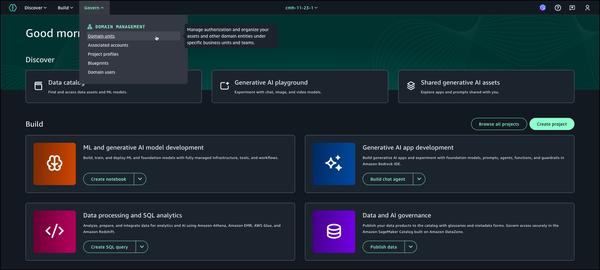

전반적으로 Llama 3.2의 출시는 대규모 언어 모델 분야에서 중요한 진전을 나타냅니다. 향상된 기능과 더 광범위한 적용성은 이미지 이해 및 시각적 추론에서 에지 애플리케이션에 이르기까지 광범위한 사용 사례의 가능성을 열어줍니다. 생성 AI 기술이 계속 발전함에 따라 Llama 3.2와 같은 모델에서 더 많은 혁신과 혁신적인 애플리케이션을 기대할 수 있습니다.